7. 하지만 활성함수가 없으면 뉴럴네트워크가 아님(Activation Function)

- 결함: 레이어가 있나 없나 결과는 비슷함

- 해결 방법 : activation function

히든 레이어에 있는 값을 활성 함수를 통해 한 번 변형시킨다.

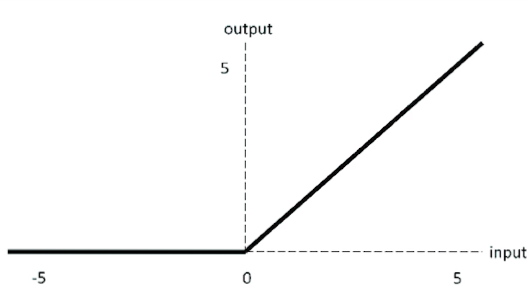

대표적인 활성 함수

1) sigmoid

2) Hyperboic tangent

3) Rectified Linear Units

- 활성 함수를 거치고 나면, 레이어가 역할을 하게 됨.

- 활성 함수가 필요한 이유는 non-linearity 예측을 하기 위해서임.

비선형적이고, 복잡한 예측이 가능함.

- activation function이 없으면 딥러닝이 아님.

- activation function은 모든 레이어에 있으면 좋지만, 출력층에는 없을 수 있음.

8. w값 찾는 방법은 경사하강법을 사용합니다. (Gradient descent)

- Loss = 예측값 - 실제값.

Loss를 최소화하는 w값을 컴퓨터가 찾는 것임.

-

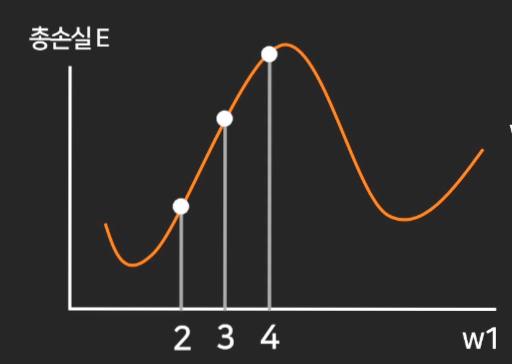

총손실이 최소가 되는 w를 찾아야 하는데, 구할 때

- 처음에는 아무런 w값을 대입함.(랜덤값)

만약 처음 값을 3으로 잡았다면, 3 주변의 총손실을 더 작게 만들 수 있는 값으로 w를 바꿔주는것이다.

변수가 w1하나면 2차원 그래프를 그려서 판단이 가능하지만, 변수가 수백개면 그림도 그릴 수 없음.

따라서 경사하강법이라는 알고리즘을 이용하여 w1을 최적값으로 변경함.

w값을 최적의 값으로 바꾸기 위해서, 현재 w1값에서의 접선의 기울기를 w1에서 뺌.

위의 이미지의 경우, 접선의 기울기가 양수이기 때문에 왼쪽으로 이동함.

위의 이미지의 경우, 접선의 기울기가 음수이기 떄문에 오른쪽으로 이동함.

따라서, 경사하강법을 이용하면 총손실이 최소가 되는 w값을 찾을 수 있음.

- 머신에게 러닝을 시킨다

= 손실을 최소화하는 w값을 찾게 시킨다.

= 그 방법이 경사하강법임.

- 딥러닝 학습과정

(1) w값들을 랜덤으로 찍음

(2) w값 바탕으로 총손실 E를 계산함.

(3) 경사하강으로 새로운 w값 업데이트.

(4) w값 바탕으로 총손실 E를 계산함.

(5) 경사하강으로 새로운 w값 업데이트.

(6) w값 바탕으로 총손실 E를 계산함.

(7) 경사하강으로 새로운 w값 업데이트.

... 반복

-> 총손실이 더이상 줄어들지 않을 때까지.

- Local minima

만약 처음 w값을 잘못 잡으면, 단순히 기울기를 빼는 방법으로는 잘못된 w값을 최적의 값(local minima)으로 결론낼 수 있음.

그러나 우리가 찾아야 하는 값은 왼쪽 화살표의 값임.

- 해결책 : 기울기만 빼지 말고, learning rate* 기울기를 빼기

- learning rate를 곱해서 빼주면, local minima를 최저점으로 결론내지 않을 수 있음.

소수점 0.00001 등의 작은 숫자를 넣어보면서, 실험적으로 해보면 됨.

- learning rate를 고정된 값만 주면 복잡한 문제의 경우 학습이 일어나지 않는 경우도 있음.

- learning rate optimizer

- Momentum : 가속도를 유지하자

- AdaGrad : 자주변하는 w는 작게, 자주변하면 크게

- AdaDelta : AdaGrad인데 a가 너무 작아져서 학습안되는거 방지해줌.

여러 개 써보면서 모델과 가장 어울리는 것을 택하면 되나 주로 아담을 쓰면 됨.

- 지금까지는 기울기라고 했으나, 실제로는 편미분을 이용함.

9. w값 역전파 알고리즘으로 업데이트 하는 법 (back propagation)

10. Tensorflow 2 빠른 기초 & 텐서플로우를 쓰는 이유 혹시 아십니까

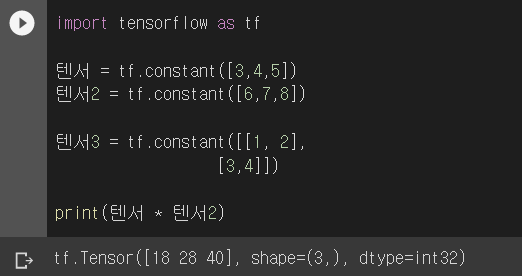

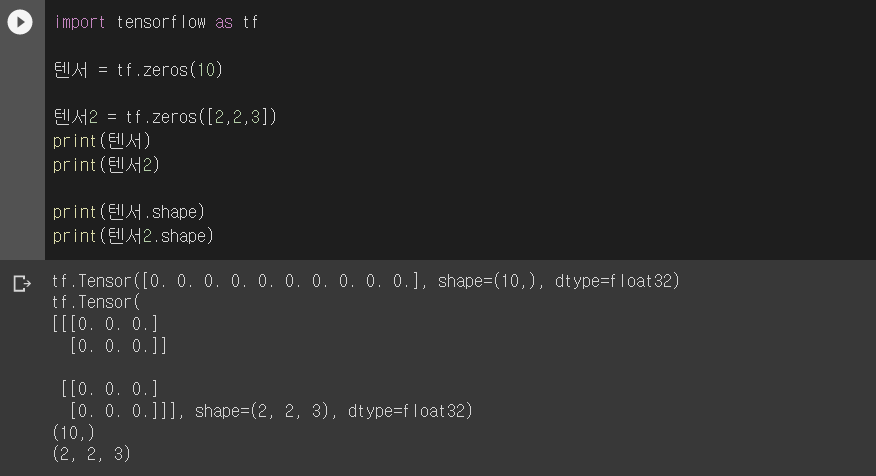

- 기본 텐서 만들기 : 텐서는 그냥 숫자, 리스트를 담는 곳임.

- 텐서가 필요한 이유 : x1w1 + x2w2 + x3w3와 같은 연산을 많이 해야함. python으로 코드를 짜려면 번거로움.

그래서 고안된 개념이 행렬임. (숫자의 나열) -> 숫자 여러개를 한 번에 계산하기 좋음.

행렬이랑 유사하게 쓸 수 있는 파이썬 코드가 텐서라는 자료형임. 행렬로 인풋/w값 저장 가능, 그럼 node값 계산식이 쉬워짐.

- tf.add()

tf.subtract()

tf.divide()

tf.multiply()

tf.matmul() 등의 함수를 이용할 수 있음.

- weight를 저장하고 싶으면 Variable에 만들기.

w = tf.Variable(1.0)

w.assign(2)

print(w)

'🔥 기술 > 인공지능 및 데이터 사이언스(AI, 컴퓨터 비전, 딥러닝)' 카테고리의 다른 글

| [AI 스터디]-3 Project 2 : 이미지 학습과 CNN (0) | 2022.06.07 |

|---|---|

| [AI 스터디]-2 Project 1 : 대학원붙을 확률을 예측해보자 (0) | 2022.06.07 |

| [AI 스터디]-1 딥러닝 이론(3) (0) | 2022.06.06 |